Kako se digitalizacija sveta ubrzano širi, naši pametni telefoni se pretvaraju u sve sofisticiranije mašine i nezamenljive alate koji imaju veliki uticaj na svakodnevni život. Oni više nisu samo uređaji za komunikaciju; oni su pametni, intuitivni asistenti, a najnovije generacije teže da budu još pametnije putem integrisanja tehnologije veštačke inteligencije (engl. artificial intelligence - AI).

Međutim, evolucija pametnih uređaja, vođenih veštačkom inteligencijom, nosi sa sobom niz novih rizika i pretnji, koje korisnici možda ne shvataju dovoljno ozbiljno.

"S jedne strane, prednosti su korisničko iskustvo, brzina dobijanja informacija i postizanje poslovnih ciljeva. Pogrešne interpretacije podataka, halucinacije i lažni sadržaj mogu se izdvojiti kao rizici", kaže Ervin Jagatić, direktor proizvoda za veštačke inteligencije u Infobipu.

Opširnije

Kripto Adria region - od pionira do iskusnih igrača

Globalno tržište platformi za razmenu kriptovaluta u snažnom je zamahu. Istražili smo kako posluju kripto-menjačnice u Adria regionu, od kojih su neke od najstarijih u svetu.

05.12.2024

Kina pokušava da sustigne Elona Muska u svemiru

Predsednik Xi Jinping želi da od Kine stvori svemirsku silu. Međutim, velika prednost SpaceX-a i bojazan Kine u vezi sa bezbednošću mogli bi da se ispreče na putu privatnim startapovima za svemirske letove u toj zemlji.

04.12.2024

Vaš sledeći finansijski savetnik biće na aplikaciji

Tržište finansijskog savetovanja pomoću veštačke inteligencije trenutno je malo, ali neminovno je da će ono rasti i da će doći do segmentacije.

12.11.2024

AI roboti za uništavanje korova pretnja su tržištu vrednom 37 milijardi dolara

Kompanije koje proizvode hemikalije za useve razmatraju nove poslovne modele jer napredna tehnologija obećava smanjenje upotrebe herbicida.

11.11.2024

Kako je ruska armija botova osvojila svet onlajn pokera

Veštačka inteligencija iz Sibira za kartanje nadmudrila je najpametnije svetske istraživače i zaradila milione.

05.11.2024

Da će novi uređaji opremljeni tehnologijom veštačke inteligencije olakšati širenje lažnih sadržaja, slaže se i Ljubiša Bojić, viši naučni saradnik i koordinator Laboratorije za digitalno društvo, Instituta za filozofiju i društvenu teoriju u Srbiji.

"AI tehnologija omogućava sve lakše i brže generisanje sadržaja koji izgleda autentično, što može dovesti do povećane količine obmanjujućih informacija u onlajn prostoru", naglašava on.

Veštačka inteligencija postaje sve dostupnija, tako da sada jednim klikom na pametnom telefonu možete izvršiti vizuelnu pretragu onoga što gledate, lektorisati tekst ili čak potpuno odgovoriti na neku poruku ili mejl. Ali niko ne bi želeo da se osetljivi podaci iz tih sadržaja otkriju ili zloupotrebe, namerno ili slučajno.

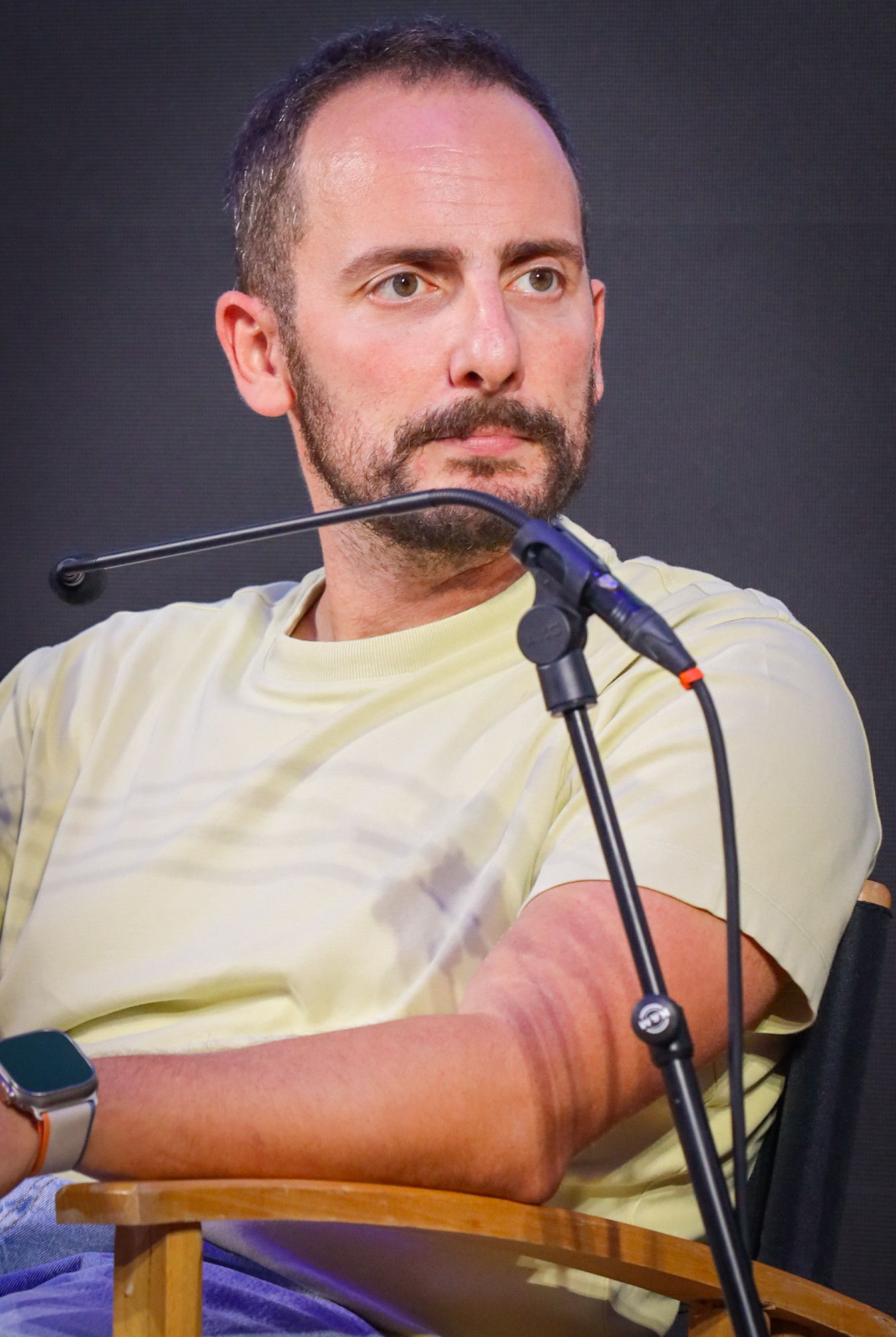

"Postoji rizik da ti podaci budu korišćeni za obuku velikih jezičkih modela (LLM) bez saglasnosti korisnika, što bi moglo da utiče na privatnost i bezbednost", objašnjava Nino Karas, izvršni direktor i suosnivač kompanije CodeWell AI.

Nino Karas / Foto: privatna arhiva

Nino Karas / Foto: privatna arhiva

Prednost koja nosi rizik

Veštačka inteligencija, u svojim različitim oblicima, postaje sastavni deo funkcionisanja savremenih pametnih telefona. Od glasovnih asistenata, poput Siri i Google Assistanta, do naprednijih funkcija kao što su opcije za predviđanje teksta i personalizovane preporuke, veštačka inteligencija poboljšava korisničko iskustvo tako što uređaje čini preciznijim i intuitivnijim. Međutim, upravo ta sofisticiranost čini ih podložnim zloupotrebama.

Jedna od glavnih briga odnosi se na podatke koje prikupljaju ovi pametni uređaji. Sistemi veštačke inteligencije zahtevaju ogromne količine podataka za efikasno funkcionisanje, a ti podaci često uključuju osetljive lične informacije. To stvara zlatnu priliku za sajber-kriminalce. Na primer, ako sistem veštačke inteligencije može da razume vaše glasovne komande, potencijalno može da presretne i zloupotrebi lične ili finansijske informacije.

Na primer, zamislite situaciju u kojoj svom virtuelnom asistentu dajete glasovnu komandu: "Proveri moje bankovno stanje". Virtuelni asistent pristupa vašem bankovnom računu i saopštava saldo. Ako ovaj asistent nema odgovarajuću zaštitu, neko ko može da presretne te podatke ili ima pristup sistemu mogao bi da dobije informacije o vašem bankovnom računu.

Jedan od načina zloupotrebe bio bi ako haker uspe da pristupi serveru gde se skladište i obrađuju ove komande, čime dobija osetljive informacije kao što su brojevi bankovnih računa, lozinke ili podaci o kreditnim karticama. U najgorem slučaju, takav napadač može iskoristiti informacije za neovlašćene transakcije ili druge vrste finansijskih prevara.

Na osnovu ovog primera može se zaključiti da integracija veštačke inteligencije sa različitim aplikacijama i servisima znači da jedna povreda bezbednosti može da ugrozi ceo ekosistem podataka. Veliki jezički modeli sve se više koriste zbog njihove sposobnosti da pružaju informacije i izvršavaju zadatke s visokom preciznošću, što već omogućava da se deo svakodnevnih aktivnosti gotovo potpuno prenese na veštačku inteligenciju. Ali ako informacije koje generišu nisu proverene, to može dovesti do ozbiljnih posledica za društvo.

"Dezinformacije nisu uvek namerne - čest problem velikih jezičkih modela jeste pojava takozvanih ‘halucinacija’, kada pružena informacija zvuči uverljivo, ali je potpuno netačna. To je i jedan od razloga zašto još uvek nema široke primene ovih modela u industrijama u kojima dezinformacije mogu da izazovu velike finansijske štete i rezultiraju pravnim posledicama", kaže Karas.

U tom kontekstu, naš sagovornik navodi još jedan primer, sa četbotom baziranim na ChatGPT-ju, razvijenim za potrebe avio-kompanije Air Canada u februaru ove godine.

"Njihov četbot je nenamerno izmislio novu politiku za refundaciju novca kupcima, što je dovelo do pravne presude prema kojoj je kompanija morala da refundira novac svim korisnicima koji su dobili tu informaciju. Iako je politika bila potpuno nepovoljna za Air Canada, sud je presudio da je obavezujuća jer je informacija poticala iz zvaničnog izvora kompanije".

Ranjivost za eksploataciju

Pametni telefoni sve češće su meta hakera koji žele da iskoriste slabosti relativno nove tehnologije. Zloglasan primer je potencijal za AI maliciozni softver, koji može da se prilagodi i razvije kako bi izbegao otkrivanje putem konvencionalnih bezbednosnih mera. Za razliku od tradicionalnog malicioznog softvera, pretnje vođene veštačkom inteligencijom mogu da uče iz svog okruženja i modifikuju svoje ponašanje kako bi zaobišle bezbednosne protokole.

Štaviše, AI algoritmima koji se koriste u pametnim telefonima može se manipulisati u zlonamerne svrhe. Slično tome, AI sistemi koji uče iz ponašanja korisnika mogu biti prevareni da donesu pogrešne odluke ili izvrše radnje zasnovane na lažnim unosima podataka.

Depositphotos

Depositphotos

Opasnost od dipfejk sadržaja i lažnog predstavljanja

Sa napretkom veštačke inteligencije, kreiranje lažnog sadržaja, poznatog kao dipfejk (engl. deepfake), postalo je stvarna i opasna pretnja. Ova tehnologija omogućava kreiranje uverljivih video ili audio snimaka koji izgledaju kao da ih napravili stvarni ljudi, ali su zapravo potpuno generisani. Ovi video-snimci mogu se koristiti za dezinformacije, prevare, pa čak i za klevetu.

Nedžad Pirić, stručnjak za digitalizaciju iz Bloomberg Adrije, ukazuje na ozbiljne opasnosti koje donosi širenje dipfejk sadržaja, posebno kada je reč o dezinformacijama, manipulaciji percepcije javnosti i narušavanju poverenja u digitalne medije. Kada je reč o uticaju na politiku, ovakvi sadržaji predstavljaju značajnu pretnju i za političku stabilnost.

Naime, oni mogu da izazovu manipulaciju javnim mnjenjem, diskreditaciju političkih kandidata, sabotiranje međunarodnih odnosa i pregovora i da izazovu političke nemire.

"Lažno prikazani govori ili aktivnosti političara mogu destabilizovati države, izazvati nepoverenje kod birača i polarizovati društvo, dok autoritarni režimi mogu koristiti ovu tehnologiju za propagandu i represiju prema opoziciji", kaže Pirić.

S druge strane, dipfejkovi predstavljaju ozbiljnu pretnju i za finansijske sisteme. Ova tehnologija može da izazove paniku na tržištu, manipuliše akcionarima i investitorima i da dovede do naglih padova ili rasta vrednosti akcija, objašnjava Pirić.

Dipfejk sadržaj takođe može da utiče i ozbiljno ugrozi ugled javnosti i poverenje u medije. Društvene mreže su verovatno najranjivije na ovu izloženost, budući da se danas koriste kao kanal za brzu i masovnu distribuciju sadržaja. Bojić naglašava da sprečavanje širenja dipfejk sadržaja na mrežama zahteva kombinaciju tehnoloških rešenja, poput algoritama za detekciju dipfejka, i edukaciju korisnika za prepoznavanje lažnih sadržaja.

Iako su lažni video-snimci koje generiše veštačka inteligencija svakim danom sve uverljiviji, stručnjaci se slažu da još uvek postoje neki znaci po kojima se može primetiti da je određeni sadržaj dipfejk.

"Često, u dipfejk video-snimcima, izrazi lica ili pokreti očiju mogu izgledati neprirodno ili neusaglašeno s glasom. Takođe, lažni sadržaj se može prepoznati ako se uoči i najmanja razlika između pokreta usana i glasa. Još jedan pokazatelj je nedostatak treptanja, neprirodno ili prečesto treptanje. Ostali pokazatelji uključuju neadekvatno osvetljenje pri čemu se mogu primetiti promene u senci ili osvetljenju lica koje ne odgovaraju prirodnim uslovima, kao i 'glatka' ili plastična tekstura kože koja izgleda neprirodno u poređenju sa stvarnim izgledom kože", objašnjava Pirić.

Privatnost i etički problemi

Upotreba veštačke inteligencije u pametnim telefonima izaziva značajnu zabrinutost za privatnost. Sistemi za AI često zahtevaju stalni pristup ličnim podacima kako bi usavršili svoje algoritme.

"Obrada i korišćenje informacija od strane korisnika je i dalje veliki problem, koji, uprkos pokušajima da se reši i zakonskom regulisanju tipa GDPR (engl. General Data Protection Regulation) EU, i dalje predstavlja veliki problem i svakodnevno vide mnoge propuste čak i od visoko etabliranih kompanija. Veštačka inteligencija dodaje složenost postojećoj situaciji, koja je, nažalost, i dalje siva zona kroz koju se kompanije ograđuju korišćenjem zakonskih mehanizama i predugo i za običnog korisnika nejasne politike privatnosti i korišćenja", ističe Karas.

Osim toga, postoje i etičke dileme. Sposobnost AI-ja da predviđa i utiče na ponašanje korisnika može dovesti do manipulacija, bilo u komercijalne svrhe ili iz drugih podlih razloga. Isti algoritmi koji preporučuju proizvode i usluge mogu se zloupotrebiti za širenje štetnog sadržaja ili dezinformacija.

Na primer, u političkom kontekstu, AI može da se koristi za identifikaciju korisnika podložnih određenim porukama, sa ciljem prikazivanja targetiranih političkih reklama ili dezinformacija. Algoritmi mogu da analiziraju emocije, stavove i uverenja korisnika, a zatim kreiraju personalizovane poruke koje utiču na njihovo mišljenje ili ponašanje, kao što je bio slučaj sa "Kembridž analitikom" (engl. Cambridge Analytica), gde su podaci sa društvenih mreža korišćeni za manipulaciju glasača.

Ublažavanje rizika

Da bi se izborili sa ovim pretnjama, proizvođači i programeri moraju dati prioritet jakim bezbednosnim merama. To podrazumeva šifrovanje podataka, strogu kontrolu pristupa sa dvofaktorskom autentifikacijom, stalno praćenje radi otkrivanja pretnji, redovno ažuriranje softvera, segmentaciju mreže i primenu pravnih i etičkih standarda. Bojić sugeriše da je u zaštiti od lažnih sadržaja generisanih pomoću veštačke inteligencije važno istovremeno razvijati alate za detekciju i verifikaciju takvog sadržaja, pri čemu se mogu koristiti i savremene metode kao što je blokčejn tehnologija.

"Koristeći blokčejn, možemo da kreiramo distribuirani, nepromenljivi zapis podataka koji obezbeđuje transparentnost i verifikaciju. Svaki sadržaj može biti haširan i digitalno potpisan, a zatim zapisan na blokčejn, omogućavajući proveru autentičnosti kroz specijalizovane AI alate za detekciju dipfejk sadržaja."

Ervin Jagatić/ Foto: privatna arhiva

Ervin Jagatić/ Foto: privatna arhiva

Kako kaže, pametni ugovori mogu da automatizuju ove procese, dok bi krajnji korisnici, preko dodataka za pretraživače, imali jednostavan pristup informacijama za verifikaciju sadržaja. Takav sistem bi značajno smanjio rizik od širenja lažnih informacija i ojačao poverenje javnosti u digitalne medije.

Štaviše, povećani regulatorni nadzor može biti neophodan kako bi se osiguralo da se tehnologije veštačke inteligencije razvijaju i koriste na način koji poštuje privatnost i bezbednost korisnika. Transparentne prakse i saglasnost korisnika treba da budu osnovni u primeni tehnologija veštačke inteligencije.

"Odgovornosti kompanija i pojedinaca mogu snažno uticati na zaštitu privatnosti i bezbednosti podataka. Korišćenje veštačke inteligencije na odgovoran način može da omogući bezbednu primenu za pojedinca", ističe Jagatić iz Infobipa.

Pravci za budućnost

Kako AI napreduje, tako će napredovati i strategije onih koji žele da iskoriste njene slabosti. Izazov za korisnike i programere je da ostanu korak ispred ovih pretnji, obezbeđujući da prednosti veštačke inteligencije ne budu na štetu bezbednosti i privatnosti.

"Neophodno je strogo testiranje i verifikacija pre masovne upotrebe algoritama, kao i transparentnost i nadzor u procesu obuke. Uključivanje ljudskog nadzora takođe pomaže u izbegavanju pogrešnih ili neetičkih odluka", dodaje Karas.

U svetu u kome su pametni uređaji centralni deo našeg svakodnevnog života, razumevanje i rešavanje skrivenih pretnji od AI nisu samo mera predostrožnosti već i neophodnost.

U pripremi teksta učestvovali: Marta Premužak, Dragana Tomić i Nejra Džaferagić.

.png)