Tehnologija kompanije ElevenLabs se već koristi da lažira političke kandidate i promoviše lažne proizvode.

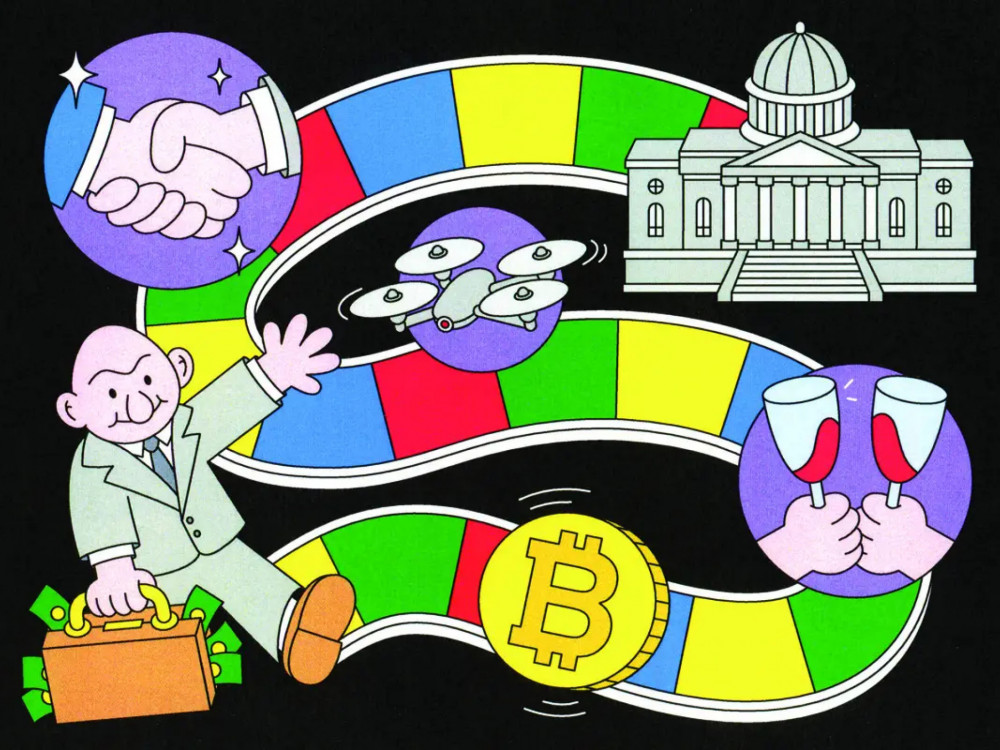

Jordan Howlett, 26-godišnjak sa 24 miliona pratilaca na Instagramu, TikToku i YouTubeu, veoma je obazriv po pitanju brendova sa kojima sarađuje. Potpisao je ugovore sa lancem restorana Domino's Pizza, kompanijama Google i WingStop i zarađuje za život kreiranjem video-snimaka o temama kao što su „otvaranje tegli kao profesionalac” ili najbolji način da „pravilno jedete iz Chipotle činija”. Bio je tako preplašen kada je počeo da dobija poruke u kojima su ga pitali zašto na Facebooku i Instagramu reklamira navodni lek za slepilo.

Howlett je kliknuo na jedan od linkova ka tim video-snimcima i užasnuto slušao kako glas koji je zvučao baš kao njegov opisuje kako su „vrhunski istraživači sa Kembridža” otkrili ritual od sedam sekundi koji svakome može dati savršen vid. Video-klip u kom su standardni rendgenski snimci mozga i sredovečni ljudi koji škilje u svoje mobilne telefone, bio je loše montiran. Ali je zato audio-snimak bio krajnje uverljiv, kaže Howlett. „Kada sam čuo svoj glas, bio sam užasnut”, kaže on. „Oni bi teoretski mogli da naprave da govorim bilo šta.”

Stručnjaci za sajber-bezbednost godinama upozoravaju na dipfejkove (lažiranja), veštački generisane ili manipulisane medije koji mogu proći kao autentični. Dok je veliki deo zabrinutosti usmeren ka fotografijama i video-snimcima, tokom prošle godine je postalo jasno da audio-dipfejkovi, koji se ponekad nazivaju klonovima glasa, predstavljaju najneposredniju pretnju. Vijay Balasubramaniyan, osnivač agencije za otkrivanje prevara Pindrop, kaže da je njegova kompanija već viđala napade na klijente banaka u kojima prevaranti koriste sintetički audio-snimak kako bi glumili vlasnike računa u pozivima korisničkoj podršci.

Howlett kaže da je bio užasnut lažnim audio-snimkom svog glasa. Fotograf: John Francis Peters za Bloomberg Businessweek

Drugi veliki strah je politička manipulacija, kao kada je 20.000 glasača Nju Hempšira dobilo poziv, navodno od predsednika Joea Bidena, pozivajući ih da ne glasaju za njega sledećeg dana. Nije bilo očiglednog praktičnog uticaja: Bidenovo ime čak nije ni bilo na glasačkom listiću, ali je ipak odneo većinsku pobedu putem kampanje glasanja poštom. Međutim, incident je pojačao zabrinutost da bi takva tehnologija mogla da ima važnu ulogu na ovogodišnjim izborima. Federalna komisija za komunikacije (engl. Federal Communications Commission) 8. februara zabranila je automatske telefonske kampanje koje koriste veštačku inteligenciju.

Agencija Pindrop kaže da je video-snimak Howletta nastao ubacivanjem snimaka njegovog govora, očito preuzetih sa njegovih YouTube ili Instagram videa, u softver koji je napravila startap kompanija ElevenLabs da bi klonirala njegov glas. Od tog trenutka, baš kao što se Howlett plašio, tehnologija kompanije ElevenLabs je dala njenom korisniku moć da stvori jezivo uverljivi audio-narativ sa njegovim glasom. Dva nezavisna istraživača su analizirala Bidenov robotski poziv i utvrdili da je zvuk takođe generisan korišćenjem ElevenLabs tehnologije.

Prijatelji iz detinjstva Mati Staniszewski, bivši strateg za implementaciju u kompaniji Palantir Technologies, i Piotr Dąbkowski, bivši Google inženjer za mašinsko učenje, osnovali su kompaniju ElevenLabs pre dve godine. Obojica su odrasla u Poljskoj gledajući holivudske filmove koji su bili nevešto sinhronizovani na poljski i mislili su da bi veštačka inteligencija mogla poštedeti današnju decu sličnog iskustva. Smatrali su da bi mogli da se koriste isti alati za predavanje onlajn lekcija ili čitanje audio-knjiga, pa čak i za prevođenje razgovora u realnom vremenu.

Ta ideja je pretvorila ElevenLabs u jedan od najaktivnijih startapova u industriji generativne veštačke inteligencije. To nije jedina usluga za kloniranje glasa, ali se izdigla na vrh. ElevenLabs je prikupio novac od investitora, uključujući Andreessena Horowitza, Smash Capital i Mustafu Suleymana, suosnivača kompanije DeepMind. Poslednja runda finansiranja, objavljena u januaru, podigla je vrednost kompanije na 1,1 milijardu dolara (1,02 milijarde evra). Ljudi koji su upoznati sa internim radom kompanije ElevenLabs kažu da uprava ne želi da se njegov proizvod koristi za kreiranje lažnog internet oglašavanja ili materijala za suzbijanje glasanja. Međutim, kao što se često događa sa uspešnim internet startapovima, alati kompanije su se širili brže nego što se razvijala zaštita protiv njihove zloupotrebe.

ElevenLabs nudi besplatnu biblioteku generičkih glasova, a potražnja za klonovima prepoznatljivih glasova je veoma brzo porasla. Ubrzo nakon predstavljanja alata u januaru 2023. godine, koji je omogućio da se klonira glas samo na osnovu kratkog audio-snimka, ElevenLabs je na Twitteru objavio da beleži „sve veći broj slučajeva zloupotrebe kloniranja glasa”. Takvi slučajevi su potekli od korisnika na veb-sajtu 4chan, koji su delili snimke podkastera Joe Rogana i glumice Emme Watson u kojima su, prema tadašnjim medijskim izveštajima, pravili rasističke i homofobne uvrede.

Lažno predstavljanje poznatih ličnosti je bila pravna dilema za kompaniju ElevenLabs. Apelacioni sud je 1988. godine odlučio da poznate ličnosti imaju pravo da zabrane komercijalnu upotrebu jedinstvenih karakteristika, kao što je njihov glas, bez njihove dozvole. (Problem je nastao kada je Bette Midler tužila kompaniju Ford Motor jer je unajmila pevačicu da oponaša njen glas nakon što je sama odbila da peva u reklamama.)

Da bi se smanjila zloupotreba, ElevenLabs je počeo da naplaćuje jedan dolar (0,93 evra) mesečno za svoj prethodno besplatni alat za kloniranje glasa. To nije poskupelo kreiranje audio-dipfejkova, ali je bilo značajno to što su korisnici morali da povežu način plaćanja koji se može pratiti, na primer, plaćanje kreditnom karticom, i što bi se time mogli odvratiti oni maliciozni. S druge strane, to će doprineti pozitivnoj primeni.

ElevenLabs kaže da ne „komentariše konkretne incidente, ali da će preduzeti odgovarajuće mere ako im se skrene pažnja na sadržaj koji krši njihove uslove”. U intervjuu za Bloomberg News u januaru, Staniszewski je rekao da su skoro sve upotrebe tehnologije kompanije legitimne i da ElevenLabs može da prati koje fraze korisnici kreiraju uz kloniranje glasa. „Svi bezbednosni napori su najvažniji”, rekao je.

Kompanija je krajem 2023. godine započela izradu plana za postupanje sa korisnicima koji imaju razne vrste loših namera, kaže osoba upoznata sa poslovanjem kompanije, koja je zatražila anonimnost kako bi razgovarala o informacijama koje nisu javne. Šef osoblja kompanije ElevenLabs Victoria Weller je bila posebno fokusirana na uspostavljanje pravila pre stupanja na snagu Zakona o internet bezbednosti Ujedinjenog Kraljevstva i evropskog zakona o digitalnim uslugama 2024. godine. Ona je želela je kreira politike u vezi sa uvredljivim jezikom i priručnik za osoblje kako bi im bilo jasno kada mogu da zabrane korisnika. Pravila korišćenja kompanije ElevenLabs zabranjuju „obmanjujuće ili zavaravajuće glasovne klonove” i „sadržaj koji podstiče nasilje ili promoviše mržnju”. Ali oni takođe priznaju da kompanija ne „prati proaktivno vaš sadržaj na njihovim uslugama”.

Pet od 40 zaposlenih u kompaniji ElevenLabs posvećeno radi na poverenju i bezbednosti. Ljudi koji su upoznati sa radom ove kompanije u intervjuima kažu da osnivači strastveno žele da spreče moguće izborne prevare ili uvredljiv jezik. Ali stručnjaci za veštačku inteligenciju i za poverenje i bezbednost kažu da je skoro nemoguće sprečiti ljude da kreiraju problematičan sadržaj pomoću javno dostupnih alata generativne veštačke inteligencije. Tehnološke kompanije generalno imaju za cilj da spreče 90 odsto štetnih aktivnosti, kaže Mohamed Abdihakim Mohammed, menadžer zajednice koji je radio na moderaciji sadržaja u brojnim softverskim kompanijama. Ali startapovi „ne mogu učiniti ništa kako bi zaustavili da tehnologija kloniranja glasa, koja je toliko dostupna, nanese štetu”, kaže on.

Bidenov robotski poziv je pokazao ograničenja tehničke zaštite kompanije ElevenLabs. Kompanija nudi alat koji naziva klasifikator govora, za koji kaže da može da utvrdi da li je audio-snimak sintetički i da li je određeni snimak kreiran pomoću njenog softvera. Bloomberg Businessweek i Pindrop su koristili alat da bi proverili jedan od Bidenovih snimaka i tehnologija je procenila da se ne radi o dipfejku. Slični alati drugih kompanija su otkrili suprotno, a nakon što je snimak očišćen od buke u pozadini, isti taj alat kompanije ElevenLabs zaključio da je dipfejk ipak bio korišćen.

Promena zaključka pokazuje kako alati za otkrivanje dipfejka postaju manje pouzdani što su dalje od izvora. Kreatori mogu da dodaju šum ili druge smetnje kako bi zavarali alate. Dosadašnji projekti provere činjenica na društvenim mrežama takođe sugerišu da bi čak i savršena detekcija imala ograničen uticaj. Kada neko napravi audio-snimak, on se može proširiti društvenim mrežama, a obmanjujući sadržaj često nađe put do publike koja nije sklona da veruje onima koji kažu da je sadržaj sa kojim se slažu nelegitiman.

Skoro 121.000 ljudi je pogledala jedan od lažnih Howlettovih videa. Više takvih bi moglo „potencijalno da poremeti buduće poslovne prilike”, kaže on. Takođe se brine da bi njegovi fanovi mogli biti dovedeni u opasnost od prevare. „Ne želim da moji pratioci budu prevareni”, kaže on.

Osim toga, tu su i izbori 2024. godine. Kreatori dipfejka sa entuzijazmom istražuju mogućnosti. Jedan od njih je Samin Yasar, kreator na YouTubeu i osnivač servisa AI Answers koji koristi audio veštačku inteligenciju kao zamenu za kol-centar. Yasar je u januaru objavio video u kom kaže da je klonirao glasove koristeći ElevenLabs u ime dve političke kampanje.

Samin Yasar. Fotograf: Amy Lombard za Bloomberg Businessweek

Inspiracija za video je bio razgovor sa Adam Wynnsom, preduzetnikom koji drži solarijum i koji je osnovao kompaniju Winningest Method, koja nudi trening životnih veština i tablete za mršavljenje. Wynns je pitao Yasara da li je moguće napraviti masivnu, automatizovanu političku telefonsku kampanju za prikupljanje anketnih informacija od birača. Rekao je Yasaru da poznaje ljude koji bi mogli da iskoriste tu tehnologiju.

Da bi dokazao koncept, Yasar je koristio ElevenLabs da klonira glas Mikea Lindella, glavnog izvršnog direktora kompanije MyPillow, politički aktivnog desničara koga je kompanija za glasačke mašine Dominion Voting Systems tužila za 1,3 milijarde dolara (1,2 milijarde evra) zbog lažnih tvrdnji o predsedničkim izborima 2020. godine. Lindell je negirao bilo kakav prestup. „Čvrsto verujem da moramo pažljivo da ispitamo naše sisteme glasanja i obezbedimo transparentnost”, objavio je audio-snimak, čitajući iz skripte koju je kreirao ChatGPT, prema uzorku koji je pregledao Businessweek. „Moji napori su usmereni na istraživanje nepravilnosti.”

Mike Lindell. Fotograf: Joshua Roberts/Bloomberg

Yasar je učitao audio-snimak na uslugu robotskog biranja. Lažni Lindell bi mogao da odgovara na pitanja i komentare birača slično automatizovanom pozivu korisničkoj službi.

Wynns kaže da je ideju izneo Lindellu i Scottu Jensenu, bivšem kandidatu republikanaca za guvernera Minesote koga su kritikovali zbog širenja dezinformacija o kovidu 19. Nikad nije dobio odgovor i na kraju je odustao od ideje pre komercijalizacije tehnologije, rekavši da su mogući pravni problemi počeli da ga čine nervoznim. Međutim, tehnički ga ništa ne bi moglo zaustaviti.

- Sa Mark Bergenom.

.png)