Hany Farid nije mogao da se oslobodi osećaja da zapravo ne razgovara sa Barackom Obamom.

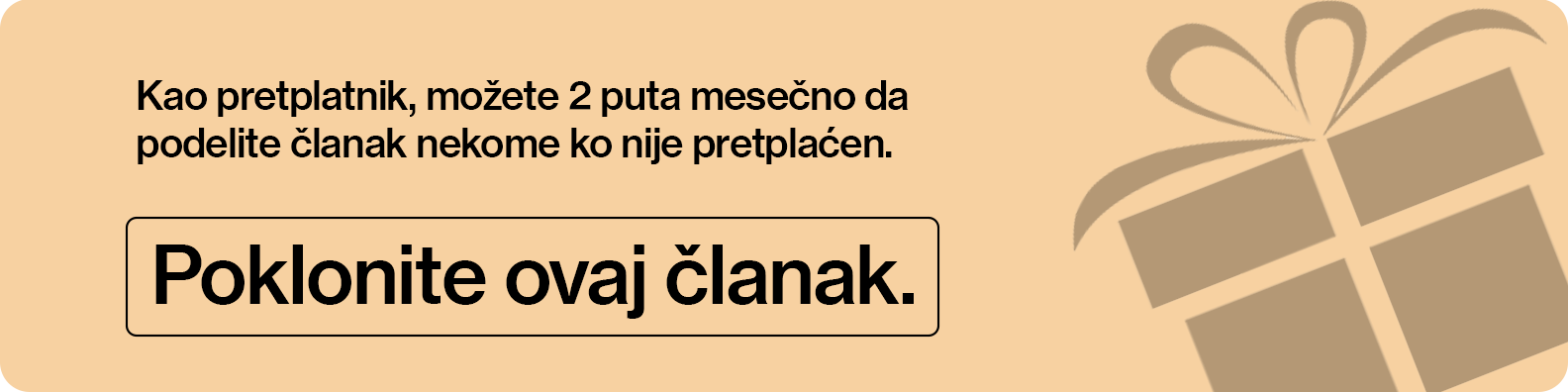

Bila je 2023. godina i jedan Obamin saradnik obratio se Faridu, profesoru kompjuterskih nauka na Univerzitetu Kalifornije u Berkliju, specijalizovanom za analizu slika i digitalnu forenziku, da bi ga pitao da li bi razgovarao s bivšim predsednikom o tehnologiji dipfejka (engl. deepfake označava digitalni audio, video ili slikovni materijal koji je veštački generisan ili modifikovan pomoću AI-ja tako da izgleda kao stvaran, ali zapravo prikazuje nešto što se nije dogodilo ili osobu koja ne izgovara ono što navodno govori, prim. prev.). Kako je video-poziv odmicao, razgovor jedan na jedan s Obamom, prepoznatljivom po glasu i ritmu govora, počeo je da deluje pomalo čudno. "Sve vreme sam razmišljao: ‘Ovo je dipfejk. Ovo nije Obama’", kaže Farid. "Hteo sam da mu kažem: ‘Stavi ruku ispred lica.’"

Opširnije

Zabrinutost oko AI potrošnje pritisla akcije nakon pada Microsofta

Sumnje u povraćaj ulaganja u veštačku inteligenciju ponovo u fokusu investitora.

29.01.2026

Osvrni se oko sebe: baloni su posvuda

Budite oprezni sa modernim ekonomskim mehurima.

30.01.2026

Kako ubrzati rast vaše kompanije pomoću veštačke inteligencije

Zamislite AI-agenta koji samostalno kreira, testira i usavršava druge AI-agente, koji potom mogu da se koriste u različitim kompanijama kako bi se drastično unapredili i automatizovali poslovni procesi.

23.01.2026

Počnimo ljubav iz početka - buđenje nuklearne energije

Nuklearna električna energija, kao proizvod civilne upotrebe vojne tehnologije, od samog početka se suočavala sa jednim velikim problemom.

25.01.2026

U to vreme, tražiti od nekoga da mahne rukom ispred lica bio je jedan od načina da se prepozna dipfejk. Slika na ekranu bi se ili izobličila i time odala prevaranta, ili ne bi. Međutim, Farid nije mogao da se natera da pogleda bivšeg predsednika u oči i zatraži od njega da dokaže da je stvaran. "Tako sam se deset minuta pitao da li me neko samo zeza", kaže Farid.

Ispostavilo se da nije bio predmet neslane šale. Međutim, Faridove sumnje govore o tome koliko je veštačka inteligencija (AI) podstakla paranoju kod ljudi koji komuniciraju putem interneta. Ta tehnologija se, takođe, ubrzano razvija kako bi zaobišla najočiglednije ljudske mehanizme odbrane. Trik s mahanjem rukom već postaje zastareo, kao što je to Farid pokazao prilikom nedavnog video-razgovora za Bloomberg Businessweek, tako što je svoje lice zamenio licem izvršnog direktora OpenAI-ja Sama Altmana. Postojalo je izvesno kašnjenje između glasa i slike, kao i tračak beživotnosti u očima, ali Farid je mogao da se počeše po obrazu i uperi baterijsku lampu u lice, a da se prikaz uopšte ne poremeti. "U načelu, gotovo je s idejom da ste na video-pozivu s nekim i da tome možete verovati."

Ljudi se pripremaju za dan kada će se mašine sasvim uverljivo ponašati kao ljudi još od bar 1950. godine, kada je Alan Turing (britanski matematičar, kriptograf i pionir računarstva, prim. prev.) predložio proveru koju je nazvao "igra imitacije". U onome što je danas poznato kao Turingov test, čovek bi vodio pisan razgovor i sa mašinom i sa drugim čovekom, a zatim pokušao da pogodi ko je ko. Ako bi mašina uspela da prevari sudiju, prošla bi test. Decenijama kasnije, veb-sajtovi redovno traže od korisnika da dokažu da su ljudsko biće tako što dešifruju iskrivljena slova i brojeve poznate kao CAPTCHA, koje ljudi relativno lako čitaju, dok se računari s njima muče. (CAPTCHA je akronim od Completely Automated Public Turing test to tell Computers and Humans Apart; Potpuno automatizovani javni Turingov test za razlikovanje računara i ljudi, prim. prev.) Kako su automatizovani alati postajali sofisticiraniji, tako su i ove digitalne zamke postajale sve naprednije. Ujedno su postajale i sve čudnije, zahtevajući od ljudi da identifikuju fotografije pasa koji se smeše i pritom još razmišljaju o tome da li psi uopšte mogu da se smeju, samo da bi kupili karte za koncert.

Pojava velikih jezičkih modela (Large Language Model, LLM; napredni sistemi AI koji su trenirani na ogromnim količinama tekstualnih podataka kako bi razumeli, generisali i obrađivali prirodni jezik; prim. prev.) probila je te zaštitne mehanizme. Istraživanja su pokazala da, uz pažljivo usmeravanje, AI agenti mogu da rešavaju složene CAPTCHA testove. U drugom, nedavno sprovedenom istraživanju u kome je učestvovalo 126 ispitanika, na nekoliko velikih jezičkih modela primenjen je Turingov test i utvrđeno da su učesnici u 73 odsto slučajeva OpenAI-jev GPT-4.5 smatrali čovekom.

U svetu koji povezuje internet, poverenje se urušava, čineći svaku interakciju podložnu visokotehnološkoj obmani, bilo da je reč o potencijalnom poslodavcu, mogućem romantičnom partneru, majci koja zove s odmora u inostranstvu ili bivšem predsedniku SAD. Prevaranti koji koriste kloniranje glasa već su se lažno predstavljali kao američki državni sekretar Marco Rubio kako bi komunicirali s ministrima spoljnih poslova drugih zemalja. Jedan zaposleni u multinacionalnoj kompaniji sa sedištem u Hongkongu poslao je 25 miliona dolara prevarantu koji je koristio dipfejk kako bi se predstavio kao finansijski direktor te firme, izvestio je CNN 2024. godine.

Sada, u nedostatku boljih rešenja, i pojedinci i institucije u hodu smišljaju svoje neformalne Turingove testove. Oni postavljaju nesvakidašnje prepreke, koje mogu biti čak u suprotnosti sa društvenim normama, kako bi potvrdili da su svesna bića i traže od drugih da učine isto. Kako mašine postaju sve bolje u oponašanju ljudi, i ljudi menjaju svoje ponašanje. Menjaju način na koji pišu, način na koji zapošljavaju i način na koji komuniciraju s nepoznatim osobama, a sve to kako ih ne bi zamenili za AI ili kako ne bi postali njena žrtva.

Elizabeth Zaborowska, nekada je bila poznata na poslu kao "kraljica dugih crta", toliko da su joj kolege na njenom prvom marketinškom poslu u Njujorku okačile znak s tim natpisom ispred njenog kancelarijskog odeljka. Zaborowska je ovaj interpunkcijski znak smatrala elegantnim sredstvom da spoji dve ideje, a da pritom ne izmeša svoje rečenice. Kada je pokrenula sopstvenu firmu za odnose s javnošću, Bhava Communications, njen tim je usvojio stil pisanja šefice, uključujući i duge crte. Međutim, ChatGPT takođe ima sklonost ka dugim crtama. Korišćenje tog znaka sada je na listi tipičnih obrazaca ponašanja po kojima se raspoznaju tekstovi generisani pomoću AI-ju. U vreme kada kompanije otpuštaju PR agencije u korist besplatnih AI alata, Zaborowska nije smela da rizikuje da bilo ko pomisli da pokušava da rad četbota predstavi kao svoj. Prošlog proleća, okupila je svoj tim na nedeljnom virtuelnom sastanku i naredila da se duge crte zauvek izbace iz upotrebe. (Treba napomenuti da OpenAI radi na tome da oslobodi svog četbota opsesije dugim crtama.)

To je najmanji mogući ustupak, gledano iz šire perspektive promena koje donosi AI. Međutim, za Zaborowsku to je nagoveštavalo nešto veće: da bi zvučala ljudski, potiskivala je svoje instinkte. "Menja se ritam jezika, a ja sam opsednuta jezikom", kaže ona.

Za Sarahu Suzuki Harvard, marketinškog pisca u agenciji za kreiranje sadržaja Storyarb, opšta potraga na internetu za tekstovima koje je pisala AI pretvorila se u "lov na veštice" koji ju je naterao da cenzuriše sopstveni rad. Nedavno je na LinkedInu progovorila o uobičajenim stilskim konstrukcijama koje se sada smatraju znakovima upozorenja na AI. Iritantno je što su ti znakovi upozorenja zapravo ljudske osobenosti koje su računari usvojili tokom treninga. "Mi smo ti koji su napravili mašine", kaže Suzuki Harvard. "One plagiraju nas."

U svakom slučaju, na ljudima je sada da dokazuju sopstvenu autentičnost. Taj problem je možda najizraženiji u univerzitetskim kampusima, gde profesori na Redditu razmenjuju strategije za otkrivanje studenata koji varaju pomoću ChatGPT-ja, dok studenti na TikToku iskaljuju bes zbog toga što su kažnjeni za svoj naporan rad koji je greškom pripisan AI. Urednici Wikipedije su se, u međuvremenu, udružili kako bi eliminisali unose generisane AI, pretražujući sajt u potrazi za očiglednim pokazateljima, poput lažnih citata, ali i za manje očiglednim, kao što su tekstovi u kojima se suviše često koristi reč "delves" (treće lice jednine od glagole "delve" na engleskom – udubiti se, dublje istraživati, proučavati detaljno, prim. prev.).

Ilyas Lebleu, jedan od osnivača grupe urednika na projektu za čišćenje te platforme od AI sadržaja, WikiProject AI Cleanup, kaže da cilj nije da se sa Wikipedije ukloni sav sadržaj koji je generisala AI, već da se odstrani nekvalitetan sadržaj, poznat kao slop (engl. slop označava pomije, šund; rečnik Merriam-Webster proglasio je "slop" za reč godine za 2025. u značenju nekvalitetnog sadržaja generisanog AI koji preplavljuje internet; prim. prev.) "Ako su informacije tačne i ako postoje pravi izvori, to je u redu", kaže Lebleu. "Najveći problem predstavlja neproveren AI sadržaj."

U svetu zapošljavanja, generativna AI omogućila je svakome da jednim klikom napravi temeljnu prijavu za posao, što je dovelo do bujice propratnih pisama i biografija kroz koje preopterećeni timovi ljudskih resursa moraju da se probijaju. Kyle Arteaga, izvršni direktor firme za odnose s javnošću i komunikacije Bulleit Group iz Sijetla, kaže da njegova kompanija u poslednje vreme prima na hiljade prijava po jednom radnom mestu i da se često desi da na kraju intervjuiše ljude koji su toliko koristili AI za traženje posla da se uopšte i ne sećaju da su se prijavili. Njegov tim je na to odgovorio postavljanjem zamki za AI u oglase za posao, tražeći od kandidata da u propratnom pismu uključe neku referencu iz pop-kulture i da navedu kojoj kući školi magije Hogvorts (škola iz serijala knjiga i filmova o Hariju Poteru ima četiri kuće: Grifindor, Sliterin, Haflpaf i Rejvenklo, prim. prev.) pripadaju. U jednom nedavnom slučaju, manje od tri odsto od više od 900 kandidata pratilo je uputstva, čime je drastično smanjen njihov broj, kaže Arteaga. (Posao je, inače, dobila osoba koja se svrstala u Rejvenklo.)

Kako bi smanjili rizik od AI prevara, ljudi se okreću i onome što Farid naziva "analognim rešenjima". Altman iz OpenAI-ja nedavno je, kao jedno od mogućih rešenja da se ljudi zaštite od glasovnih klonova koji se predstavljaju kao članovi porodice, sugerisao da porodice smisle sigurnosnu reč koju mogu zatražiti u kriznim situacijama. Krajem prošle godine, britanska Starling Banka pokrenula je marketinšku kampanju u okviru koje je podsticala svoje klijente da urade isto. Prema podacima Starlinga, 82 odsto ljudi koji su videli poruku reklo je da će verovatno poslušati ovaj savet.

Drugi koriste uobičajena trik pitanja kako bi potvrdili da li je neko čovek na internetu. Pranava Adduri kaže da je nedavno tokom razgovora sa onlajn agentom korisničke službe tražio od agenta da definiše Navier-Stokesove jednačine, skup matematičkih jednačina koje opisuju kretanje viskoznih fluida. Svaki ambiciozni četbot, obučavan na celokupnom svetskom znanju, požurio bi da pruži odgovor, kaže Adduri, koji je suosnivač i glavni tehnički direktor kompanije za bezbednost podataka Bedrock Data Inc. iz Menlo Parka u Kaliforniji. Međutim, agent je samo odgovorio: "Nemam pojma."

"Pomislio sam, ‘Okej, čovek si’", kaže Adduri.

Sve veći broj kompanija, uključujući Google, deo kompanije Alphabet Inc, vraća se intervjuima uživo, kojima četbotovi, po pravilu, ne mogu da prisustvuju. Portparol Googlea kaže da se kompanija odlučila na to kako bi se novi zaposleni lakše privikli na njenu kulturu, kao i da se uveri da kandidati imaju osnovne veštine programiranja neophodne za pozicije za koje konkurišu.

Međutim, Google i ostale velike korporacije i iz drugih razloga žele da se lično sretnu sa novim zaposlenima. Prema podacima Federalnog istražnog biroa (FBI), IT radnici iz Severne Koreje, krijući identitet, uspešno su dobili poslove u više od 100 američkih kompanija, predstavljajući se kao radnici na daljinu. Ove prevare, koje se često oslanjaju na AI alate, omogućile su da se stotine miliona dolara godišnje sliva u Severnu Koreju, a u njih su čak bili upleteni i američki građani.

"Nije tajna da postoje lažni kandidati", kaže Kelly Jones, glavna direktorka za ljudske resurse u kompaniji Cisco Systems Inc, koja navodi da je kompanija u svoj proces prijava uključila i biometrijsku verifikaciju.

Sve veća potreba za dokazivanjem da je neko ljudsko biće, dovela je, prirodno, do pojave nove oblasti tehnoloških rešenja. S jedne strane, tu su alati za razotkrivanje dipfejkova koji se integrišu u postojeće platforme, kao što je Zoom, i navodno detektuju sintetički audio i video-sadržaj u realnom vremenu. JPMorgan Chase & Co. koristi jedan takav alat, pod imenom Reality Defender, u svojoj komunikacionoj mreži. Farid je suosnivač sopstvene kompanije, GetReal Security, koja takođe nudi alate za otkrivanje dipfejkova u realnom vremenu, kao i druge usluge digitalne forenzike.

S druge strane, tu su alati koji obećavaju da će proveriti da li je neko zaista čovek putem kriptografskih ili biometrijskih metoda. Najistaknutiji među njima je Orb, uređaj za skeniranje očne jabučice koji je razvila kompanija Tools for Humanity, čiji je suosnivač Sam Altman. Orb koristi skeniranje dužice oka kako bi proizveo identifikacioni kôd za koji njegovi tvorci kažu da funkcioniše kao digitalni pasoš. Taj kôd, nazvan World ID, može se potom validirati putem aplikacije World App kad god korisnik treba da potvrdi svoj identitet. Iako programeri kažu da sistem ne čuva lične podatke o korisnicima, sama ideja izazvala je poprilične strahove od distopijskih, represivnih pojava. Neke zemlje, uključujući Brazil, išle su tako daleko da su ga zabranile.

Orb i drugi sistemi za dokazivanje ličnosti zavisili bi od jednog entiteta, bilo da je to privatna kompanija, vlada ili nevladina organizacija, koji bi izdavao te potvrde i tako stekao ogromnu moć. To su, takođe, dugoročna rešenja koja zahtevaju široku društvenu i institucionalnu podršku, a Farid kaže da je kriza poverenja na internetu upravo problem kojim se sada treba pozabaviti.

Svako od ovih navodnih rešenja, u rasponu od duge crte, kao znaka interpunkcije, do Orba, podrazumeva određene kompromise, bilo da se od ljudskih bića zahteva da podele nešto o sebi ili da izvedu nešto da bi dokazali da su ljudi. Stigli smo do tačke u evoluciji AI-ja gde smo mašine koje koriste verovatnoću za donošenje odluka, obučili da budu previše dobre u predviđanju onoga što bi čovek uradio u bilo kojim datim okolnostima. Sada smo se, da bismo se razlikovali od njih, našli u situaciji da pokušavamo da shvatimo to isto – šta bi čovek uradio.

.png)